Synthèse

Une IA au coeur de tous les secteurs et du quotidien des Français

Au cours de la dernière décennie, l’intelligence artificielle (IA) s’est imposée dans de multiples sphères : nos vies personnelles et professionnelles, les industries, mais aussi les services de l’État et l’action des collectivités territoriales. Cette diffusion massive soulève de nouveaux enjeux, qui touchent autant à la conception des modèles d’IA qu’à la capacité de leurs utilisateurs – citoyens, entreprises, décideurs politiques ou acteurs publics et privés – à en comprendre les mécanismes. Ainsi, les problématiques d’inclusion numérique se prolongent aujourd’hui dans un effort d’inclusion algorithmique, nécessitant des actions ciblées auprès de l’ensemble des parties prenantes afin de garantir des usages durables et équitables de l’IA. Cette inclusion algorithmique met en lumière trois dimensions essentielles : sociale, économique et territoriale.

Des perspectives marquées à l’échelle territoriale

Les collectivités territoriales voient désormais se multiplier les cas d’usage de l’intelligence artificielle. L’IA n’est plus seulement un horizon d’avenir : elle s’ancre déjà dans le présent, au plus près des territoires. La diversité des applications possibles est considérable : amélioration de la relation avec les administrés, simplification des démarches internes, optimisation des politiques publiques, rationalisation des dépenses de fonctionnement. Pourtant, la réussite de ces projets repose sur la maturité des collectivités et de leurs décideurs : comprendre le fonctionnement des systèmes d’IA, en mesurer le potentiel mais aussi les limites, est une condition indispensable pour les mettre efficacement au service du territoire, sans céder aux illusions technologiques ni aux projets superflus. Les études récentes révèlent en outre de fortes disparités dans l’appropriation de l’IA par les collectivités. Ces écarts ne sauraient être comblés par une approche descendante et centralisée : ils appellent au contraire des réponses adaptées aux réalités locales.

Des territoires inégaux face aux risques de discriminations

De nombreux scandales ont montré que les technologies pouvaient générer des discriminations, en produisant des traitements différenciés et injustes selon le genre, l’âge, l’origine ethnique, l’orientation sexuelle ou encore la classe sociale. À ces biais de conception s’ajoutent aujourd’hui de nouveaux risques liés aux usages des IA génératives, où la prise en main par l’utilisateur peut orienter fortement les résultats et renforcer des stéréotypes. À l’échelle territoriale, le danger est celui d’une IA à deux vitesses : les espaces urbains, mieux représentés dans les jeux de données et donc favorisés, face aux territoires ruraux, périphériques et ultramarins, souvent réduits à des représentations stéréotypées et confrontés à des usages plus limités. Ces écarts risquent de renforcer des inégalités préexistantes, au détriment de la cohésion sociale et territoriale.

Un besoin d’inclusion algorithmique à plusieurs dimensions

Les enjeux d’inclusion algorithmique s’inscrivent dans la continuité des efforts d’inclusion numérique initiés dès les années 1990. Portés par un réseau dense d’acteurs de terrain et appuyés, de manière plus ou moins soutenue, par l’État et les pouvoirs publics, ces efforts visent désormais un nouvel horizon : permettre à chacun de tirer pleinement parti des usages de l’intelligence artificielle.

L’inclusion algorithmique peut être pensée à travers quatre dimensions complémentaires :

- l’accès aux technologies, aux réseaux et aux machines ;

- l’usage, c’est-à-dire la capacité à manipuler ces outils avec aisance et à en tirer le meilleur parti ;

- la compréhension de leur fonctionnement, indépendamment de l’âge, du niveau d’éducation ou de la familiarité avec ces technologies ;

- la conception, fondée sur une gouvernance exigeante, garantissant l’éthique et la prévention des discriminations.

L’implication nécessaire de décideurs politiques éclairés

Le principal frein à l’adoption de l’intelligence artificielle dans les collectivités réside aujourd’hui dans le manque de compétences et de confiance des élus et des agents. Leur formation et leur accompagnement constituent donc la première étape indispensable pour développer une IA véritablement au service de l’intérêt général local.

Des décideurs dotés d’une culture algorithmique solide seront mieux armés pour :

- impulser la conception d’outils adaptés aux spécificités de leur territoire ;

- en assurer l’évaluation et le pilotage dans la durée ;

- structurer et stimuler des politiques locales d’inclusion algorithmique.

À la croisée de tous les acteurs concernés, ils occupent une position charnière. Leur volonté politique et leur capacité d’entraînement conditionnent la réussite des projets d’IA, en permettant l’émergence d’initiatives ambitieuses et réellement inclusives.

Un accompagnement continu et mobilisant tous les acteurs impliqués

L’appropriation de l’IA repose sur la mobilisation d’une grande diversité de « passeurs » présents dans la vie quotidienne : médiateurs numériques, structures d’éducation populaire, communauté éducative et universitaire, acteurs de la formation professionnelle et des ressources humaines. Tous contribuent à diffuser les clés de compréhension nécessaires pour saisir le fonctionnement, les finalités et les impacts des algorithmes et de l’IA.

Cette pluralité d’espaces et d’acteurs rend indispensable un décloisonnement des démarches d’accompagnement. La coopération entre secteurs public, privé et associatif doit s’intensifier, car trop d’initiatives fonctionnent encore en vase clos, limitant leur portée et leur efficacité.

Concevoir l’IA sous l’angle d’une gouvernance d’excellence

La gouvernance des algorithmes désigne l’ensemble des pratiques visant non seulement à garantir la conformité avec la loi, mais aussi à incarner les principes éthiques définis par l’organisation qui en assure la maîtrise. Elle doit ainsi aller au-delà du respect des obligations légales, pour adopter une vision prospective de la conception et de l’usage des outils algorithmiques, qu’il s’agisse d’une institution publique, d’une collectivité ou de l’État.

Une telle gouvernance repose sur plusieurs piliers :

- une collaboration étroite entre équipes métiers et techniques à toutes les étapes de conception ;

- la montée en compétences des collaborateurs, des citoyens et des utilisateurs finaux ;

- des tests rigoureux sur les jeux de données et sur l’algorithme, en amont comme en aval, du développement à l’usage ;

- l’adoption de bonnes pratiques de développement garantissant fiabilité, transparence et qualité dans la durée.

Cette approche exigeante constitue la condition d’une IA digne de confiance, au service de l’intérêt général.

Un besoin de coalitions locales et de transversalité

Face au déploiement des systèmes d’intelligence artificielle, nombre de collectivités se trouvent démunies, faute de moyens humains, techniques ou financiers. La mutualisation de ces ressources apparaît alors comme une réponse essentielle, permettant de lever ces freins et de dépasser un développement de l’IA encore trop cloisonné, qui entrave à la fois l’innovation et la transformation des organisations.

Ce décloisonnement ne doit toutefois pas se limiter aux collectivités elles-mêmes ou aux partenariats entre elles : il doit s’étendre à l’ensemble des acteurs de terrain – éducatifs, associatifs, entrepreneuriaux – afin de bâtir des coalitions locales capables de porter une véritable inclusion algorithmique au service des territoires.

Au-delà de l’inclusion individuelle et collective, cette démarche favorise le renforcement d’une souveraineté technologique territoriale et nationale. Elle passe par l’émergence et le soutien d’acteurs locaux et nationaux du domaine, ainsi que par la conception de solutions adaptées aux besoins et spécificités de chaque territoire.

Introduction – L’inclusion algorithmique, nouvel horizon de l’intelligence artificielle

Depuis le déploiement public d’Internet à la fin des années 1990, puis après une première ère dite de big data dans les années 2000, les usages du numérique se sont profondément ancrés dans notre quotidien, entraînant une transformation majeure du rôle de l’État, à la fois acteur et garant de ces mutations. Un vaste écosystème d’acteurs publics et privés a oeuvré pour assurer l’inclusion numérique de tous les citoyens en développant l’accès à un réseau de qualité (via la fibre optique et des technologies alternatives), l’accès aux terminaux numériques (ordinateurs, téléphones portables…) ou encore notre capacité collective à utiliser les outils et les applications numériques.

Cette dernière décennie a vu l’émergence d’outils d’intelligence artificielle (IA) dans différents pans de nos vies personnelles et professionnelles, dans de nombreuses industries, ainsi que dans les services de l’État français et des collectivités territoriales. De cette transformation naissent de nouveaux enjeux, tant du côté de la conception des modèles d’IA que dans la capacité de compréhension de leur fonctionnement par leurs utilisateurs, qu’ils soient citoyens, entreprises, décideurs politiques, et plus généralement acteurs publics et privés. L’inclusion numérique se prolonge en une inclusion dite algorithmique, appelant des actions à mener auprès de l’ensemble de ces acteurs pour garantir l’implémentation et la durabilité d’usages d’IA bénéfiques à tous. Cette inclusion algorithmique engage des dimensions essentielles, à la fois sociales, économiques et territoriales.

Nous proposons dans cette étude une réflexion portant tant sur l’état de l’art, sur l’analyse des efforts d’appropriation et de diffusion de l’IA impulsés sur l’ensemble du territoire que sur des propositions concrètes destinées à favoriser une inclusion algorithmique au sein de notre société, de tous les territoires, pour permettre à chacun de mettre l’IA au service de son quotidien, et non son quotidien au service de l’IA.

I. Pourquoi parler d’inclusion algorithmique ?

1. Des technologies algorithmiques de plus en plus présentes

Nous interagissons au quotidien, souvent sans le réaliser, avec des technologies algorithmiques (aussi appelées intelligences artificielles car le ou les algorithmes qui les constituent en assurent la logique de fonctionnement) pour nous déplacer, nous soigner, apprendre, construire, communiquer ou encore travailler1Voir Brian Christian et Tom Griffiths, Algorithms to Live By. The Computer Science oh Human Decisions, Picador, Londres, 2016.. Ces interactions se multiplient dans nos vies personnelles et professionnelles, peu importe notre âge, notre classe sociale, notre niveau d’éducation, notre genre ou encore le secteur d’activité dans lequel nous évoluons. Cette forte pénétration masque néanmoins des usages variés et plus ou moins émancipateurs en fonction de nombreuses variables sociodémographiques, et la numérisation de certains secteurs, en particulier administratifs, peut-être un fort vecteur d’inégalités2Voir Clara Deville, L’État social à distance. Dématérialisation et accès aux droits des classes populaires rurales, Éditions du Croquant, Vulaines-sur-Seine, 2023..

Les algorithmes qui font fonctionner ces outils apportent une dimension supplémentaire aux générations précédentes d’applications numériques uniquement, autrement dit sans intelligence artificielle : elles requièrent une connaissance minimale de leur fonctionnement chez l’utilisateur, dont le comportement va conditionner en partie la logique d’exécution sous-jacente. En pratique, si les outils numériques facilitent l’accès à l’utilisateur, leurs algorithmes avancés l’appréhendent désormais au travers de ses interactions avec la technologie. En cela, saisir les limites de ces mêmes algorithmes et l’étendue de ce qu’ils peuvent exécuter, telles que leurs capacités réelles3Voir Aurélie Jean, De l’autre côté de la machine. Voyage d’une scientifique au pays des algorithmes, Éditions de l’Observatoire, Paris, 2019 ; Yann Le Cun, Quand la machine apprend. La révolution des neurones artificiels et de l’apprentissage profond, Odile Jacob, Paris, 2019 ; Luc Julia, L’intelligence artificielle n’existe pas. Le cocréateur de Siri déconstruit le mythe de l’AI, First, Paris, 2019. qui excluent toute forme de maîtrise d’émotion, de créativité ou d’intelligence pratique propres à l’humain4Voir Robert J. Sternberg, Beyond IQ: A Triarchy Theory of Human Intelligence, Cambridge University Press, Cambridge, 2009 ; Daniel Andler, Intelligence artificielle, intelligence humaine : la double énigme, Gallimard, Paris, 2023. est fondamental pour les prendre en main de manière éclairée. Aussi, connaître l’existence de discriminations technologiques5Voir Cathy O’Neil, Weapons of Math Destruction. How Big Data Increases Inequality and Threatens Democracy, Crown, New York, 2016 ; Kate Crawford, Contre-Atlas de l’intelligence artificielle, Zulma, Paris, 2022 ; Joy Buolamwini, Unmasking AI. My Mission to Protect What Is Human in a World of Machines, Random House, New York, 2023. permet là encore d’utiliser ces outils en connaissance de cause. Le simple fait de comprendre le type d’algorithme utilisé (de recommandation, de correspondance, de catégorisation, de prédiction…) et le type de données sur lequel il a été calibré, entraîné et sur lesquelles il opère, constitue une étape essentielle vers une adoption active, éclairée et, au besoin, critique.

2. Des avancées scientifiques remarquables

Même si la modélisation algorithmique computationnelle (destinée à être exécutée automatiquement sur un ordinateur) n’est pas une science nouvelle6Voir Panos Louridas, Algorithms, The MIT Press, Cambridge (MA), 2020 ; Aurélie Jean, Les Algorithmes, Que sais-je ?, Paris, 2024., elle a percé ces deux dernières décennies du fait, entre autres, de l’augmentation des capacités de calcul (ou puissance des ordinateurs incluant les serveurs), de l’amélioration des solveurs et des algorithmes, et des progrès dans la collecte et le transport de grandes quantités de données, à travers par exemple la miniaturisation des capteurs dans les outils connectés (ou IoT pour Internet of Things). L’apprentissage automatique (machine learning)7Voir Ethem Alpaydin, Machine Learning, The MIT Press, Cambridge (MA), 2016. et particulièrement l’apprentissage profond (deep learning)8Voir John D. Kelleher, Deep Learning, The MIT Press, Cambridge (MA), 2019. ont certainement le mieux et le plus profité de ces avancées significatives.

Comme toute révolution, si une quelconque révolution due à l’IA existe, elle ne pourra assurément être soulignée qu’une fois celle-ci passée ou largement entamée. De manière générale, la modélisation algorithmique appliquée à un domaine permet de rendre ce dernier plus prédictif, plus précis ou plus personnalisé9Voir Aurélie Jean, Mark Esposito, Terence Tse et Danny Goh, « Winning Strategies for the High-Stakes AI Arena: Unveiling an Innovative AI Research and Development Planning Framework and Matrix », europeanbbusiness.com, 14 novembre 2024.. On en comprend alors les perspectives prometteuses dans de nombreuses disciplines qui vont voir leurs contours se transformer telles que la médecine, la finance, l’éducation ou encore le transport, la logistique et l’énergie. Les révolutions seront successives et certainement applicatives.

3. Une présence marquée à l’échelle territoriale

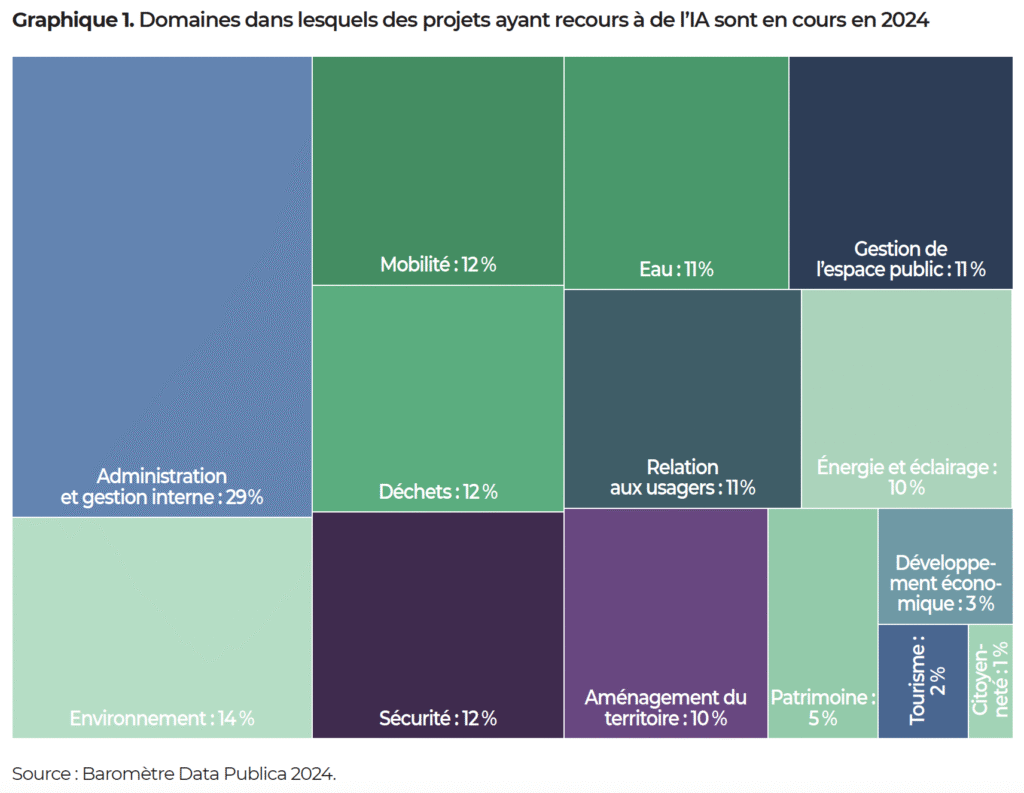

Les perspectives et les cas d’usage pour les collectivités territoriales commencent à se multiplier. L’IA n’est plus seulement un horizon recouvrant de nombreux possibles, mais un présent qui se matérialise à l’échelle locale. Un guide publié en 2019 donnait un très large éventail d’applications envisageables pour les collectivités, allant de la décongestion du trafic à la gestion des épidémies, en passant par l’inclusion des personnes et la détection de mobilier endommagé, mais sans pouvoir apporter des cas d’étude aboutis et en nombre10Banque des territoires-Caisse des dépôts, Guide Intelligence artificielle et collectivités, 2019.. Aujourd’hui, les collectivités ayant engagé des programmes dépassant la phase du projet sont plus nombreuses : en 2021, la Commission européenne recensait cinq projets locaux en France, le Conseil d’État en citait dix-neuf en 2022 et l’Observatoire Data Publica en prévoyait une cinquantaine en 2023. En 2024, c’est plus d’une collectivité sur deux qui a engagé ou compte engager un projet mobilisant l’IA, sous des formes très diversement complexes ou abouties11Observatoire Data Publica, Baromètre de l’observatoire Data Publica. Les collectivités territoriales et la donnée, 3e édition, 2024, p. 38-39.. Une note de conjoncture publiée par la Banque des territoires met en avant plusieurs cas d’usage déjà bien avancés12Banque des territoires, Data, intelligence artificielle et cybersécurité dans les territoires, 8 novembre 2024. :

- à Noisy-le-Grand, des outils permettent de modéliser et d’anticiper l’impact des travaux de rénovation sur la consommation énergétique des bâtiments publics ;

- à Plaisir et à Issy-les-Moulineaux, des outils d’IA générative permettent de fluidifier la relation avec les usagers ;

- à Bourges, un système de détection des décharges sauvages a permis d’identifier des contrevenants et de réduire le nombre de dépôts illégaux ;

- à Rouen, au Havre et dans d’autres communes, un modèle d’IA générative propose une assistance à la rédaction de documents officiels…

La Banque des territoires propose quatre axes d’utilisations de l’IA à l’échelle des collectivités :

- génération de contenus textuels : des outils d’IA générative pour produire du contenu administratif et des documents officiels, des éléments de communication, analyser offres et dossiers…

- traitement de contenus textuels : des outils de langage à des fins d’analyse, de traduction automatique ou de réponse aux usages…

- analyse (prédictive) : l’emploi de modèles d’apprentissage automatique pour de la modélisation prédictive, du pilotage des politiques publiques en temps réel, de l’aide à la décision, de l’évaluation…

- analyse vidéo et photo : l’emploi de modèles de vision par ordinateur pour la gestion de l’espace public ou les diagnostics territoriaux…

Nombre de ces propositions sont orientées vers la simplification du travail des agents (ou plutôt d’une partie de ce travail et pour une partie des agents), en particulier sur des tâches jugées répétitives et sans valeur ajoutée humaine. Lors d’une matinée de réflexion organisée par la Banque des territoires en marge du Sommet pour l’action sur l’IA qui s’est déroulé en février 2025, la ville de Suresnes a présenté son expérimentation d’un assistant mis à disposition des agents, afin de répondre aux questions des citoyens au guichet ou par téléphone, en leur proposant automatiquement des ressources pour apporter des réponses pertinentes. Selon les premiers retours du directeur des systèmes d’information de la commune, les agents semblent accueillir favorablement cet outil.

Pour autant, ainsi que le souligne un rapport sénatorial, à l’échelle nationale comme locale, ces évolutions se produisent selon des schémas et des temporalités différentes13Voir Amel Gacquerre et Jean-Jacques Michau, rapporteurs, L’IA et l’avenir du service public. Rapport thématique #4 : IA, territoires et proximité, Sénat, Délégation à la prospective, rapport n° 342 (2024-2025), 2024.. Il en résulte des risques d’une appropriation à deux vitesses entre territoires, selon la culture numérique et le degré de confiance que les utilisateurs et décideurs accordent à ces outils.

II. Un développement et une prise en main disparates et discriminants

1. Des crises technologiques, sociales et démocratiques

Dans le passé, de nombreux scandales et controverses de discriminations technologiques ont été identifiés et se sont en général traduits par un traitement différent et injuste d’individus sur la base du genre, de l’âge, de l’ethnicité, de l’orientation sexuelle ou encore de la classe sociale. On peut citer les premières solutions de reconnaissance faciale dans les années 2010, qui n’identifiaient pas les visages de personnes de couleur14Voir Joy Buolawmibni, « How I’m fighting bias in algorithms » (vidéo), ted.com, novembre 2016., l’application Apple Card en 2019, qui attribuait des lignes de crédit jusqu’à vingt fois plus élevées à un homme qu’à une femme ayant les mêmes revenus et le même historique de crédit, ou encore l’algorithme de découpage automatique des photos sur Twitter (aujourd’hui X), qui recadrait automatiquement les images autour des femmes jeunes, blanches et minces. En 2024, en France, plusieurs associations ont déposé un recours devant le Conseil d’État pour attaquer une solution algorithmique utilisée par la Caisse nationale des allocations familiales (CNAF) en vue d’orienter ses contrôles. L’algorithme en question, qui se fondait non pas sur des comportements suspects mais sur d’autres caractéristiques, telles que la composition du foyer ou le niveau de revenus, pouvait entraîner des discriminations directes ou indirectes envers certains allocataires sur la base de leur classe socio-économique. Ces discriminations sont le résultat d’un biais – dit algorithmique – introduit au sein des données d’entraînement ou des décisions réalisées sur les hypothèses ou les conditions d’utilisation de la technologie en question. D’une certaine manière, ces biais sont le reflet de nos propres biais cognitifs, structurellement inscrits dans la société, mais également de ceux propres aux créateurs, majoritairement des hommes de moins de 35 ans, selon un sondage de 2021.

À ces cas de discriminations technologiques, on peut adjoindre les scandales liés à des usages abusifs de données à caractère personnel, telle l’affaire Cambridge Analytica, à des manipulations d’opinion et autres propagations de théories du complot et de fausses nouvelles sur les réseaux sociaux15Voir François Bernard Huyghe, La Désinformation. Les armes du faux, Armand Colin, Paris, 2016., ou encore à l’impact environnemental grandissant16Voir Qiang Wang, Yuanfan Li et Rongrong Li, « Ecological footprint, carbon emissions, and energy transitions: the impact of artificial intelligence (AI) », Humanities and Social Science Communications, vol. 11, art. 1043, nature.com, décembre 2024. de modèles d’IA de plus en plus énergivores (en particulier les grands modèles de langage)17Voir Kate Crawford, op. cit.. L’ensemble de ces composantes mène à une sorte de crise technologique maladroitement articulée dans les médias et le débat d’idées, lequel est encore porté trop souvent par des non sachants de la discipline. Les acteurs du champ, parmi lesquels les scientifiques, les ingénieurs, et les chercheurs, subissent les conséquences de cette panique morale s’établissant autour de l’IA jusque dans les plus hautes instances politiques et économiques. Celle-ci peut, selon les cas, conduire à sous-estimer l’impact d’une telle transformation ou à véhiculer des mythes et des stéréotypes sur la discipline. Ce fut le cas en septembre 2023 lorsque la présidente de la Commission européenne, Ursula von der Leyen, a plaidé pour la création d’un « panel mondial » d’experts afin d’évaluer les risques de l’IA pour l’humanité tels que son extinction18« IA : Ursula von der Layen souhaite un “panel d’experts”, sur le modèle du GIEC », le figaro.fr, 13 septembre 2023..

La lettre publiée par le Future of Life Institute en mars 2023, demandant un moratoire de six mois sur les développements en IA19« Pause Giant AI Experiment: An Open Letter », futureoflife.org, 22 mars 2023., illustre cette crise par son absence de pertinence scientifique et par une vision long-termiste et apocalyptique, déconnectée de la réalité des acteurs de l’IA. Qu’on s’entende bien : s’il est nécessaire de pouvoir partager ses craintes et de discuter des menaces de l’IA, cela doit se faire avec rigueur et responsabilité comme cela est fait dans plusieurs livres20Voir Cathy O’Neil, Weapons of Math Destruction. How Big Data Increases Inequality and Threatens Democracy, Crown, New York, 2016 ; Kate Crawford, Contre-Atlas de l’intelligence artificielle, Zulma, Paris, 2022 ; Joy Buolamwini, Unmasking AI. My Mission to Protect What Is Human in a Worrld of Machines, Random House, New York, 2023. et films documentaires tels que Coded Bias. Dans différents domaines (professionnel, scolaire, social…), la pandémie de Covid-19 a mis en lumière les difficultés rencontrées par beaucoup de Français dans leur appropriation des outils numériques imposés, matérialisant un éloignement au numérique. Ainsi, 36 % des Français déclarent connaître au moins un frein à leur utilisation du numérique et 44 % d’entre eux font face à des difficultés lorsqu’ils doivent réaliser des démarches en ligne21Crédoc, Baromètre du numérique. Rapport, arcep.fr, mars 2025, p. 23 et 287-289.. La pandémie a également été une période marquée par une forte désinformation et mésinformation scientifique et médicale, en France comme à l’échelle mondiale22Voir Saif F. Abed, Sophie Allain-loos et Nahoko Shindo, « Comprendre la désinformation dans le contexte des urgences de santé publique : le cas de la Covid-19 », Relevé épidémiologique hebdomadaire, 99e année, n° 4, 26 janvier 2024, p. 38-48., symptôme d’une crise générale de confiance dont l’IA est elle aussi la cible, à travers les nombreux mythes et fantasmes qu’elle suscite dans toutes les générations, notamment celui du remplacement des humains par les machines. Une désinformation et une mésinformation largement répandues aujourd’hui par les outils que nous utilisons pour partager des informations voire des actualités, tels les réseaux sociaux, qui fonctionnent grâce à des algorithmes. Cette crise encore en cours traduit une sorte de populisme scientifique, en résonance – ou en opposition – avec un populisme plus général qui met en exergue une politique de l’émotion et du ressentiment23Voir Eva Illouz, Les Émotions contre la démocratie, Premier Parallèle, Paris, 2022..

2. Une double discrimination à l’ère des IA génératives

Parallèlement à la discrimination technologique précédemment vue et induite par une conception biaisée, une seconde discrimination s’inscrit par une prise en main fortement orientée au temps des IA génératives. L’appropriation et la compréhension des outils par les utilisateurs deviennent des enjeux de taille à l’ère des IA génératives, popularisées en novembre 2022 lors de la mise à disposition publique de la troisième version de ChatGPT, développée par l’organisation OpenAI. Force est de constater que ce déploiement public de ChatGPT3 n’a nullement été conçu en tenant compte de l’utilisateur, sans objectif de le préparer à la prise en main d’un tel outil. Les conséquences ont été plurielles, tant dans la perception par les utilisateurs des réelles capacités de ces IA que dans les extrapolations abusives sur l’influence de telles technologies sur le travail, la créativité24Voir Aurélie Jean, Luc Julia, Luc de Brabandère et Martin Saive, « 5 mythes à déconstruire sur l’IA générative », hbrfrance.fr, 10 février 2024. et l’humanité en général. Une étude récente a d’ailleurs souligné des disparités de genre dans l’adoption d’IA génératives comme ChatGPT dans le contexte professionnel, avec une plus faible utilisation chez les femmes qui percevraient leur emploi comme une tricherie25Voir Anders Humlum et Emilie Vestergaard, « The Adoption of ChatGPT », Université de Chicago, Becker Friedman Institute for Economics Working Paper n° 2024-50, papers.ssrn.com, 14 mai 2024..

En pratique, la prise en main générale des IA génératives, qu’elles soient textuelles, audio ou visuelles, influence directement la qualité de la réponse générée à travers son exactitude, sa précision, voire sa véracité. Cela dépend souvent de l’âge ou du niveau d’éducation de l’utilisateur. On comprend alors l’impact et le cercle vicieux que ces IA génératives installent chez les utilisateurs au capital culturel moins important26Voir Pierre Bourdieu, « The Forms of Capital », in John Richardson (dir.), Handbook of Theory and Research for the Sociology of Education, Greenwood Press, New York, 1986., qui maîtrisent un langage moins riche au regard des exigences attendues dans la construction des requêtes (ou prompt en anglais). Même chez des utilisateurs experts d’une discipline, possédant un niveau d’éducation a priori élevé, on observe des différences de reproductibilité et de précision dans les réponses générées selon l’outil utilisé27Voir Paul F. Funk et al., « ChatGPT’s Response Consistency: A Study on Repeated Queries of Medical Examination Questions », European Journal of Investigation in Health, Psychology and Education, vol. 14, n° 3, 8 mars 2024, p. 657-668..

De toute évidence, un double enjeu d’inclusion se dessine à l’ère des IA génératives : une inclusion de conception, dans la manière de concevoir ces outils afin d’éviter les discriminations technologiques, et une inclusion d’usage, dans leur adoption par l’ensemble des utilisateurs28Voir Aurélie Jean et Guillaume Sibout, « Pourquoi les IA génératives entraînent une double discrimination ? », hbrfrance.fr, 19 janvier 2025.. À l’« illectronisme » (ou illettrisme numérique)29Voir Élie Maroun, « Illectronisme et illettrisme : la question des compétences minimales pour maîtriser les outils numériques », Informations sociales, n° 205, février 2022, p. 33-37. et aux multiples formes d’éloignement au numérique s’ajoute aujourd’hui l’illettrisme algorithmique (et ses différentes formes d’éloignement à l’algorithmique) qui traduit l’incapacité chez l’utilisateur à comprendre et à utiliser correctement ces outils. Force est d’en déduire que l’inclusion numérique tant évoquée gagne aujourd’hui à se prolonger en une inclusion algorithmique, attentive aussi bien à la conception qu’à la prise en main des technologies.

Certains territoires, en particulier ruraux ou périurbains, se heurtent à une autre forme de discrimination technologique face aux IA, et des IA génératives en particulier. Plus précisément, la construction de modèles algorithmiques à partir de jeux de données principalement collectés en milieu urbain30Voir Amel Gacquerre et Jean-Jacques Michau, op. cit. accroît sensiblement le risque de biais à l’encontre des organisations et des populations rurales ou périurbaines.

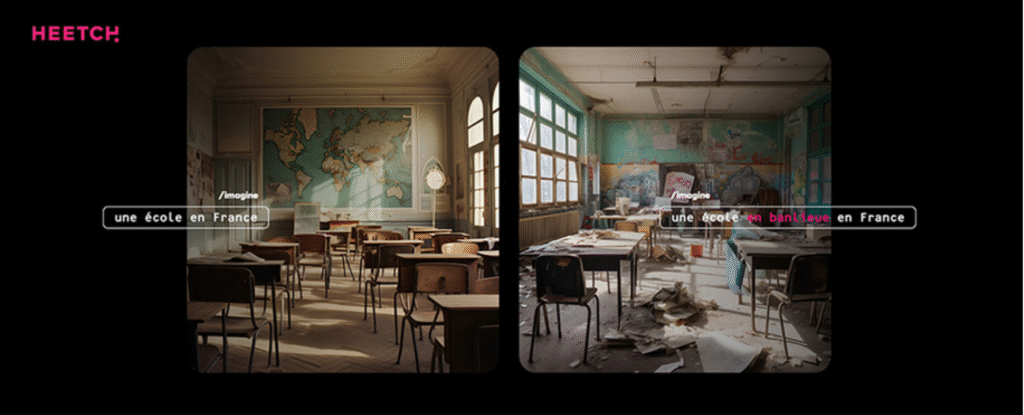

Les stéréotypes liés aux représentations de certains territoires peuvent également sortir renforcés de ces processus. En 2023, l’entreprise Heetch avait lancé une campagne dénonçant la représentation des banlieues par les IA génératives : une requête demandant de générer une image d’école en France affichait une salle immaculée, tandis qu’une requête demandant de générer une image d’école en banlieue en France rendait une salle délabrée, aux murs couverts de graffitis. En 2025, c’est le Syndicat national des journalistes de France Télévisions qui s’était déclaré inquiet de l’usage d’images générées par l’IA pour illustrer une émission de France 5 consacrée aux territoires d’outre-mer, celles-ci véhiculant un certain nombre de stéréotypes. Ces questions de représentation des territoires périphériques, qu’ils soient non urbains ou non hexagonaux, dans les systèmes d’IA et les données sur lesquelles ils sont entraînés, peuvent mener à une sorte d’uniformisation culturelle31Voir Anne Alombert, « L’intelligence artificielle peut-elle être collective ? », laviedesidees.fr, 11 février 2025. au détriment des populations rurales, périurbaines ou ultramarines.

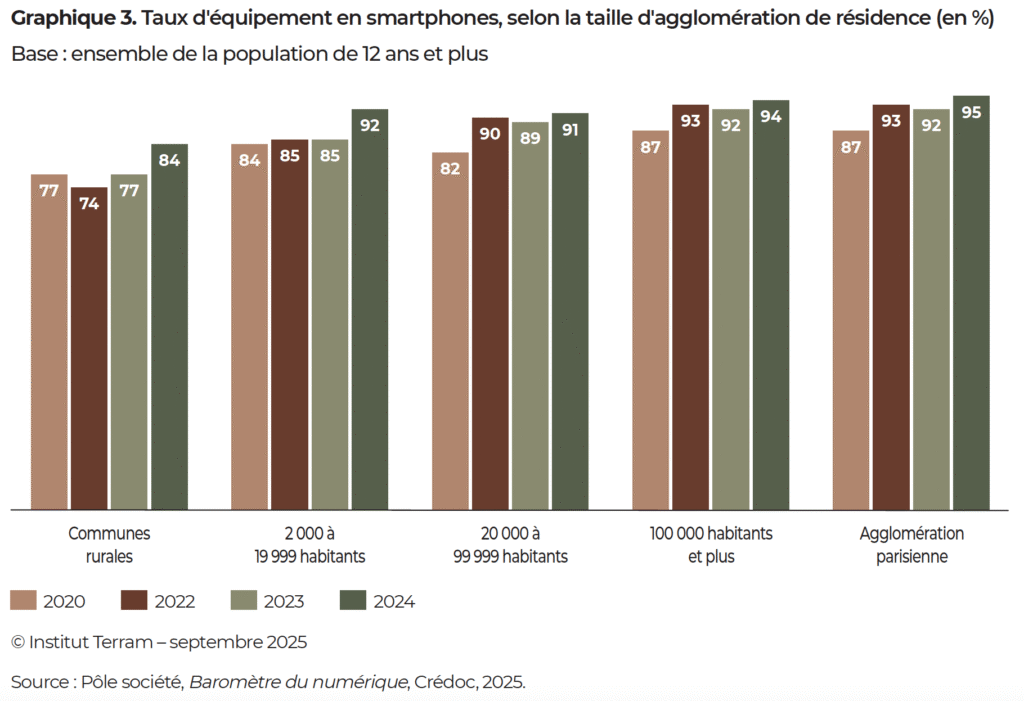

Enfin, les habitants des zones les moins densément peuplées sont triplement pénalisés vis-à-vis de ces outils. Ils connaissent des taux d’équipement et de connexion moins hauts et des usages moins fréquents que ceux des zones plus densément peuplées, malgré un rattrapage notable ces dernières années32Crédoc, op. cit., p. 8.. Il faut néanmoins voir dans ces écarts l’expression d’autres variables, les habitants des communes rurales étant en moyenne plus âgés et moins diplômés, et de ce fait plus sujets à l’éloignement numérique. En plus d’une prise en main plus difficile et d’une interface utilisateur propre aux IA génératives pour laquelle les réponses dépendent de la précision de la requête et de la qualité du dialogue, les modèles nouvellement construits s’entraînent sur les données comportementales de ces utilisateurs pénalisés, ce qui amène à des modèles algorithmiques possiblement biaisés en retour. On peut dès lors imaginer que ces publics rencontreront davantage d’obstacles dans l’usage de ces outils, s’éloignant encore plus d’une transformation algorithmique qui touche l’ensemble de la société, y compris les services publics et administratifs, au-delà de leurs usages personnels et professionnels.

3. Une prise en main disparate à l’échelle territoriale

Si le développement d’outils d’IA spécifiquement conçus pour les organisations territoriales progresse dans plusieurs collectivités, cet engouement doit toutefois être relativisé. En premier lieu, bien que certaines collectivités tentent de prendre en main des outils et des solutions appuyés sur des modèles d’IA, leur diversité est telle que le simple fait d’engager un projet n’indique pas nécessairement une réflexion aboutie, une maîtrise des outils ou leur mise au service de la collectivité et de ses habitants. Ainsi, l’usage d’un outil d’IA générative par un agent pour écrire un courriel est difficilement comparable à la mise en oeuvre d’un projet d’IA destiné à repenser le fonctionnement de la collectivité dans son intégralité.

On distingue par ailleurs des disparités entre strates et types de collectivités. Les régions et les métropoles sont largement engagées dans ces projets (respectivement 75 % et 62 % d’entre elles), tandis que les petites communes sont plus prudentes (14 % des communes de 3 500 à 10 000 habitants, ce qui représente déjà un fort progrès, puisque ce taux était de 0 % en 2023)33Observatoire Data Publica, op. cit., p. 39.. La question de la formation et de l’accompagnement des plus petites communes dans leur appropriation de l’IA se pose donc évidemment, d’autant plus que ces dernières ne disposent généralement pas des ressources leur permettant de mobiliser des équipes dédiées, comme c’est le cas pour les plus grandes collectivités, et ce malgré l’existence de structures de mutualisation.

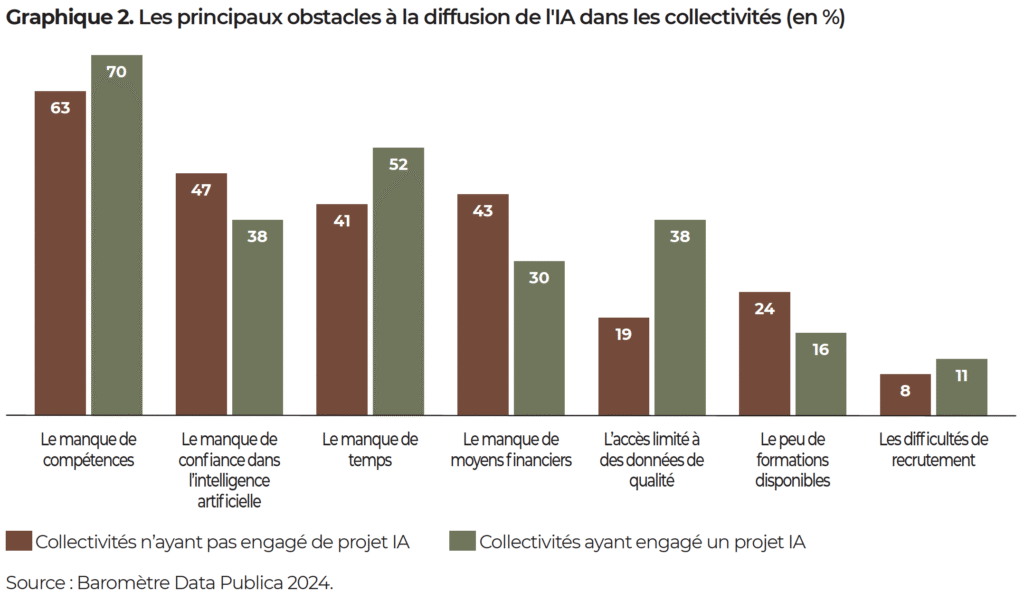

Les principaux freins à l’intégration de ces outils dans des projets locaux sont clairement établis. L’observatoire Data Publica indique le manque de compétences comme principal frein pour 63 % des collectivités qui n’ont pas lancé de projet et 70 % pour celles l’ayant déjà fait, suivi par le manque de confiance dans les systèmes d’IA (respectivement 47 % et 38 %), puis le manque de temps (41 % et 52 %), et de moyens (43 % et 30 %) ainsi que l’accès à des données de qualité (respectivement 19 % et 38 %)34Ibid., p. 45..

De plus, les collectivités doivent composer avec la méfiance des citoyens. En mai 2024, une enquête indiquait que seulement 27 % des Français estimaient avoir les compétences nécessaires à l’utilisation des IA génératives et que 79 % d’entre eux avaient des craintes concernant l’émergence des intelligences artificielles générales (en augmentation depuis 2023). De même, un Français sur trois témoignait d’une évolution de sa confiance dans l’authenticité de l’information à cause de ces outils35Ifop, Baromètre 2024 « Les Français et les IA génératives », enquête réalisé pour Talan, avril 2024, p. 23-26..

En conséquence, il serait illusoire de penser que les collectivités sont égales dans leur prise en main du développement de l’IA. Le rapport de la délégation sénatoriale à la prospective précédemment mentionné se conclut sur trois scénarios : le premier est celui de la « méfiance assumée », marquée par des réticences de la part des citoyens et des acteurs locaux envers des projets d’IA ; le deuxième est celui du « tâtonnement prudent », dans lequel certains acteurs locaux investissent du temps et des moyens dans des projets, mutualisent leurs actions et permettent le développement d’une filière spécialisée, entraînant un développement très disparate ; le troisième est celui de la « mise en oeuvre ordonnée », soutenue par une forte coordination des acteurs locaux et un cadre national permettant un déploiement rapide et standardisé. Les rapporteurs sont clairs : ce troisième scénario « n’est clairement pas celui qui se dessine à court terme » et il faut donc s’attendre à voir le deuxième perdurer36Voir Amel Gacquerre et Jean-Jacques Michau, op. cit., p. 36-39.. Il revient aux collectivités de prendre la main sur l’identification, la préfiguration, le financement et le déploiement de projets pertinents à leur échelle, mais également d’accompagner les citoyens et les autres acteurs locaux (associatifs, entrepreneuriaux…) dans cette appropriation collective.

Il est donc indispensable de réfléchir à la manière dont citoyens, collectivités et organisations territoriales peuvent être accompagnés et dotés des moyens nécessaires pour comprendre ces technologies, se les approprier et les mettre au service de leur quotidien. C’est tout l’enjeu de l’inclusion algorithmique.

III. Une inclusion algorithmique à penser selon plusieurs dimensions

Les enjeux d’inclusion algorithmique s’inscrivent dans le prolongement des efforts déjà engagés depuis les années 1990 autour de l’inclusion numérique, lesquels, plus ou moins soutenus par l’État et les pouvoirs publics, sont portés par un maillage impressionnant d’acteurs de terrain. L’Agence nationale pour la cohésion des territoires (ANCT) cartographie plus de treize mille lieux d’inclusion numérique portés par une large variété d’acteurs publics, privés et associatifs : centres sociaux et bibliothèques, mairies et espaces France services, tiers-lieux et locaux associatifs, bus itinérants, points d’accueil et d’écoute, services des impôts ou de la Caisse d’allocations familiales (CAF), agences France travail, et même une pirogue France Services en Guyane… Cette diversité témoigne du caractère protéiforme des enjeux soulevés par la diffusion des outils numériques dans notre quotidien et des ressources proposées à ceux qui en sont éloignés. Elle marque aussi le besoin d’adapter aux spécificités locales les réponses apportées aux problématiques d’inclusion et de garantir à ces acteurs l’autonomie indispensable à cette adaptation.

Depuis trois décennies, la perception de l’éloignement au numérique et les variables permettant de le quantifier ont connu plusieurs évolutions. Une étude publiée en 2023 met en lumière les difficultés persistantes à qualifier comme à quantifier ce phénomène, l’usage de termes tels que « fracture numérique » ou « illectronisme » ayant tendance à en proposer une lecture binaire, au détriment de la diversité des situations qui traduisent pourtant une réalité plurielle. Elle explore néanmoins trois focales permettant de cerner la construction des politiques de médiation37ANCT-Crédoc-Université Rennes 2-Cread-M@rsouin, La Société numérique française : définir et mesurer l’éloignement numérique, 2023, p. 5-6. :

- d’abord, une focale centrée sur l’accès, c’est-à-dire le fait d’être ou non utilisateur d’Internet ou d’outils numériques. Cet accès ou son absence peuvent être influencés par la couverture du territoire en termes d’infrastructures tout comme par la capacité de chacun à disposer d’un équipement ou d’une connexion Internet ;

- ensuite, une focale centrée sur les compétences, c’est-à-dire le fait de savoir utiliser certains outils, de réaliser certaines démarches. Cette focale explique bien la difficulté qu’il y a à quantifier précisément cet éloignement : quelles variables choisir pour déterminer les compétences indispensables à cette maîtrise ? Envoyer un courriel, réaliser une déclaration d’impôts en ligne, organiser une visioconférence… ? Elle pose également la question de la définition des compétences associées à la maîtrise de l’IA et des outils appuyés sur cette dernière ;

- enfin, une focale centrée sur les capabilités, qui interroge les conditions nécessaires à une prise en main des outils qui permette de les mobiliser au bénéfice des utilisateurs.

Ces trois focales viennent nourrir les réflexions sur les efforts d’inclusion algorithmique déployés à l’échelle locale. Il s’agit non seulement de comprendre l’origine et le fonctionnement des outils d’IA, de savoir les manipuler ou de rédiger un prompt impeccable, mais aussi de permettre à chacun de choisir les usages les plus adaptés à sa situation et de mettre ces outils au service de son quotidien. À cela, nous ajoutons ici la focale de la conception de ces outils qui, selon leur design, peuvent fonctionner différemment en fonction du profil des utilisateurs, menant éventuellement à une discrimination technologique qui menace l’appropriation des outils, et plus généralement l’inclusion algorithmique.

L’inclusion algorithmique peut donc être pensée, analysée et conçue selon ces quatre dimensions :

- accès, qui traduit l’accès aux technologies, en termes d’infrastructures « la couverture Internet » ou la possession d’un ordinateur (incluant le smartphone) ;

- usage, qui traduit l’adoption d’une technologie et en particulier l’aisance dans sa manipulation ;

- compréhension, qui traduit la connaissance des éléments fondamentaux du fonctionnement algorithmique de la technologie ;

- conception, qui traduit la construction juste, précise et inclusive des algorithmes sous-jacents aux technologies.

L’inclusion algorithmique implique l’investissement de différents acteurs : les citoyens, les décideurs politiques (à l’échelle nationale ou locale), les passeurs, qui favorisent l’appropriation du numérique et des outils d’IA, et les acteurs de l’IA (concepteurs et propriétaires des outils).

1. Convaincre les décideurs politiques à agir pour plus d’inclusion algorithmique

La volonté politique est déterminante pour impulser des projets mobilisant des modèles d’IA au service des habitants ou de l’efficacité des collectivités, pour créer des structures favorisant l’appropriation de ces technologies et pour soutenir les initiatives de médiation numérique. On peut rappeler que, dans les territoires, le manque de compétences et le faible niveau de confiance sont en général les deux principaux freins au développement d’expérimentations territoriales autour de l’IA38Observatoire Data Publica, op. cit., p. 45.. Il est donc indispensable de favoriser chez les élus et les agents des collectivités la capacité de compréhension et d’usage des technologies d’IA, afin de leur permettre de saisir l’ensemble des enjeux (opportunités, défis et menaces) qu’elles portent à leur échelle39Mis en place en janvier 2024 par la direction interministérielle du numérique, le Campus du numérique public – destiné à la formation des acteurs de la fonction publique – pourrait pleinement assumer cette mission au service des trois publics..

L’un des premiers enjeux pour un élu est d’identifier les besoins à l’échelle de sa collectivité dans une perspective d’amélioration de son fonctionnement, et pour lesquels des solutions algorithmiques s’avéreraient pertinentes au regard des orientations et priorités politiques et financières locales. Dans cette perspective, le partage des retours d’expérience des élus et des agents doit aider à concrétiser les investissements envisagés, en convainquant les plus hésitants à sauter le pas. Ces retours devraient être aussi exhaustifs que possible, y compris sur les expérimentations qui ont échoué, riches d’enseignements. En mars 2025, et dans cette logique, l’association de collectivités Les Interconnectés a mis en ligne une bibliothèque d’IA territoriales destinée à mutualiser et à documenter les expérimentations menées par des collectivités, en partant du besoin, pour ces dernières, de se concentrer sur des projets dont l’utilité est réelle et de bénéficier d’un partage d’expérience de la part des organisations ayant déjà engagé des projets.

Les structures qui mutualisent des services numériques à l’échelle locale pour soutenir la transformation doivent s’engager dans les efforts en faveur d’une plus grande inclusion algorithmique. Par exemple, les opérateurs publics de services numériques (OPSN), déjà présents dans plusieurs territoires, permettent aux élus de naviguer dans un écosystème complexe dont les nombreux acteurs les sollicitent toujours davantage. Le Syndicat mixte d’informatique communale (Smic) des Vosges a ainsi proposé des temps d’échanges à ses adhérents afin d’explorer le fonctionnement et les promesses de l’IA pour leurs collectivités. De son côté, le Syndicat mixte d’ingénierie pour les collectivités et territoires innovants des Alpes et de la Méditerranée (Sictiam) a récemment accompagné le département du Var dans cette appropriation. En étendant leur action à l’IA, les OPSN peuvent donc prolonger leur rôle essentiel de sensibilisation et d’accompagnement dans le choix et le déploiement d’outils adaptés aux besoins locaux.

Au sein d’une collectivité, il est essentiel de sortir les politiques numériques d’une logique verticale. Aujourd’hui encore, les directions du numérique sont souvent perçues comme des directions métiers, au même titre que celles des affaires sociales, de l’environnement ou du tourisme. Ce fonctionnement empêche de penser et de collaborer transversalement, ce qui est pourtant nécessaire dans la perspective d’une transformation numérique et algorithmique. Tous les élus et les directions sectorielles devraient pouvoir reconnaître l’intérêt d’investir les enjeux de l’IA afin de répondre à leurs besoins. L’existence d’une direction transversale dédiée à la transformation numérique et à l’IA, intervenant pour sensibiliser l’ensemble de la collectivité, mener une réflexion globale et accompagner la mise en place d’outils adaptés à chaque métier, semble alors favoriser cette prise en main croisée et collaborative. En cela, il convient de veiller à ce que, contrairement à ce qui a pu être observé dans nombre d’organisations publiques et privées lors des précédentes transformations numériques et data, la responsabilité de la transition vers l’IA ne soit pas cantonnée à la seule direction des systèmes d’information. Les équipes des directions des systèmes d’information (DSI) doivent se concentrer sur la cybersécurité et les infrastructures fondamentales au développement et à l’exécution de solutions algorithmiques. La transformation algorithmique doit être pilotée par les métiers de la data et de l’IA qui accompagnent l’inclusion algorithmique aux côtés des directions sectorielles.

2. Un accès inclusif, équitable et généralisé aux technologies

La capacité de chacun à comprendre et à s’approprier les outils d’intelligence artificielle demeure étroitement conditionnée par leur accessibilité matérielle et technique. Celle-ci recouvre non seulement la possession, le prêt ou le partage d’un terminal (ordinateur, smartphone), mais également l’existence d’une connexion Internet de qualité suffisante pour les usages envisagés. S’y ajoute, dans certains cas, l’acquisition de licences souvent onéreuses, condition préalable à l’utilisation des services les plus performants. Il convient toutefois de souligner que certaines pratiques, notamment celles visant au développement de l’esprit critique à l’égard du numérique, peuvent être menées hors ligne et indépendamment de tout équipement.

La focale portant sur les conditions d’accès au numérique a été à l’origine de nombreuses politiques publiques nationales et de leurs déclinaisons locales.On peut citer le plan France Très Haut Débit, adopté en 2013 avec l’objectif de couvrir l’ensemble du territoire Français (avec une couverture complète originellement prévue à l’horizon 2022, puis 2025, voire jusqu’en 2030 pour certaines régions), mais aussi le don de matériel informatique à des structures de médiation par des entreprises, comme le fait, parmi d’autres, le Groupe La Poste.

Du côté de l’accès à Internet, la couverture en connexion très haut débit est presque étendue à l’ensemble du territoire : dès 2021, 99 % des foyers et entreprises pouvaient être raccordés à un réseau très haut débit, par la fibre optique ou des moyens alternatifs, et le nombre d’abonnements en haut et très haut débit poursuit sa hausse. Ce taux d’accès est toutefois contrasté en fonction des territoires : dans les collectivités d’outre-mer, par exemple, un rapport du Conseil économique, social et environnemental (CESE) pointe certaines disparités au niveau de la couverture en très haut débit par la fibre : certains territoires affichent des taux plutôt faibles, comme Saint-Barthélemy (60 %) ou la Martinique (65 %), tandis que d’autres affichent des taux supérieurs à ceux de l’Hexagone (88 %), comme la Réunion (93 %)40Danielle Dubrac et Pierre Marie Joseph, rapporteurs, Mieux connecter les Outre-mer, Conseil économique, social et environnemental (CESE), octobre 2024, p. 94..

Du côté de l’accès au matériel informatique, en 2024, 89 % des Français possèdent un ordinateur à leur domicile et 91 % sont équipés d’un smartphone (84 % en milieu rural)41Crédoc, op. cit., p. 7.. Si ces chiffres, en constante hausse ces dernières années, font apparaître un léger décalage de l’accès au numérique en défaveur des espaces les moins densément peuplés, il faut noter que cet écart tend à se réduire.

Ces chiffres ne doivent néanmoins pas masquer les difficultés que certains Français peuvent éprouver dans leur accès au numérique faute de moyens ou de possibilité de raccordement (les 91 % du taux d’équipement en smartphones impliquent nécessairement que 9 % des Français n’en disposent pas) et la complexité de certaines situations, par exemple dans les communes de montagne ou dans certains territoires d’outre-mer. Les efforts de facilitation de l’accès au numérique, qu’il s’agisse de couverture, d’abonnements ou de matériel, doivent donc être poursuivis.

IV. Favoriser l’appropriation des technologies algorithmiques

La formation et l’accompagnement à la compréhension des modèles d’IA impliquent une mobilisation fondamentale à destination des citoyens mais également – et même avant toute chose – des passeurs qui seront en mesure de concrétiser cet accompagnement.

1. Comment évaluer le niveau d’appropriation des technologies algorithmique des citoyens et des passeurs ?

Il est difficile de dresser un tableau exhaustif des compétences et des connaissances qui peuvent être associées aux enjeux de formation et d’accompagnement à tous les sujets qui concernent l’IA. En 2022, le Conseil national du numérique a proposé une définition d’un socle de culture numérique, insistant notamment sur l’apprentissage des bases de la programmation informatique, des sciences algorithmiques et de la donnée, de l’économie numérique, ainsi que sur l’étude des impacts du numérique sur nos interactions à travers les sciences humaines et l’histoire. En appliquant un tel paradigme à l’inclusion algorithmique, on pourrait y ajouter la compréhension de la construction des modèles, de leur finalité et de leurs opportunités en rendant les disciplines plus précises, plus prédictives et plus personnalisées42Aurélie Jean et Mark Esposito, Playing to Win at the High-Stakes AI Table. Introducing a New AI R&D Planning Framework and Matrix, The Digital Economist, 2024.. On peut également penser aux menaces de ces modèles telles que la discrimination technologique, l’impact environnemental et celui sur le travail, ou encore les phénomènes de bulle de filtre, la propagation des fausses informations et tous les phénomènes propres aux IA génératives tels que les hallucinations, les bulles génératives, ou encore l’effet Eliza par l’antropomorphisation grandissante de ces technologies. La maîtrise des termes permet une première avancée dans la prise en main éclairée des outils et des sciences sous-jacentes.

Pour favoriser cette compréhension, un effort doit être déployé vers l’ensemble des citoyens afin de proposer des opportunités d’apprentissage et de prise en main dans chacune des sphères dans lesquelles il est susceptible d’évoluer (publique, scolaire, professionnelle…). L’appropriation et l’usage d’outils reposant sur l’IA ne s’improvisent pas. Une attention particulière doit donc être portée à celles et ceux qui accompagnent et forment au quotidien les Français dans leur rapport au numérique, quels que soient les lieux où s’exerce cet accompagnement.

2. Renforcer l’appropriation dans les espaces de médiation

Beaucoup d’acteurs ont déjà intégré l’IA à leur champ d’action au sein de l’important maillage des lieux de médiation numérique. Ce sont des espaces où des Français éloignés du numérique reprennent la main sur des outils qui peuvent les dépasser, voire les angoisser. Ce sont des lieux d’apprentissage de manipulations des outils, de réalisation de démarches et de pratiques numériques, mais également de développement d’un esprit critique et d’une culture numérique, vecteurs d’émancipation individuelle et collective.

Certains espaces spécifiquement dédiés à l’appropriation de l’IA, incluant l’usage et la compréhension, ont été créés. Portée par le département des Alpes-Maritimes, la Maison de l’intelligence artificielle (MIA), implantée sur le site de Sophia Antipolis, est intervenue auprès de cent mille personnes depuis sa création en 2020, en ouvrant ses portes au grand public (de nombreux formats sont proposés aux personnes âgées, à des écosystèmes professionnels…) et en intervenant plus spécifiquement auprès des publics scolaires dans l’ensemble des collèges du département (75 % de ces établissements ayant déjà été sensibilisés).

À l’échelle nationale, des programmes viennent soutenir ces actions. La démarche Café IA, pilotée par le Conseil national du numérique (CNNum), cherche à diffuser une culture du numérique chez tous les citoyens en soutenant de multiples initiatives qui encouragent les discussions et le partage de connaissances. Des rencontres conviviales sont organisées sur l’ensemble du territoire national, tant dans l’espace public qu’au sein d’organisations (établissements scolaires et universitaires, entreprises, salons professionnels, ateliers de médiation…). Clara Chappaz, ministre déléguée chargée de l’Intelligence artificielle et du Numérique, a indiqué souhaiter toucher deux millions de Français d’ici à 2026 avec ce dispositif.

La formation des médiateurs aux enjeux d’IA, tant dans leurs pratiques que dans l’accompagnement de leurs publics, est donc un sujet essentiel. Depuis 2025, la Mednum, société coopérative nationale des acteurs de l’inclusion et de la médiation numérique, propose un programme de formation permettant aux médiateurs d’animer un Café IA avec leurs publics afin de développer des connaissances « sur l’histoire, le fonctionnement et les impacts des IA ».

La situation du secteur est néanmoins sujette à de nombreuses interrogations alors que des coupes budgétaires frappant des programmes d’inclusion numérique, tels que celui des conseillers numériques piloté par l’ANCT, ont soulevé de vives inquiétudes dans la filière et au-delà. Les budgets consacrés aux politiques de médiation et d’inclusion numérique et algorithmique devraient donc être sanctuarisés afin d’assurer la pérennité d’actions essentielles et souvent fragiles. Il semblerait en effet aberrant que ce secteur devienne une variable d’ajustement budgétaire au vu de son importance fondamentale et stratégique pour le développement, le déploiement et l’appropriation d’une IA qui soit réellement mise au service de l’intérêt collectif.

3. Accompagner l’intégration dans la sphère professionnelle

La vie professionnelle constitue pour les Français l’un des principaux lieux d’expérimentation de l’IA : s’ils sont 26 % à déclarer avoir déjà utilisé des outils d’IA dans un cadre privé en 2024, 22 % l’ont fait dans un cadre professionnel43Crédoc, op. cit., p. 17.. Cette utilisation peut prendre différentes formes : intégrée de manière formelle dans la stratégie de l’organisation, plus informelle à travers des échanges de pratiques entre collègues, ou encore de façon souterraine, dans le cadre du phénomène dit de shadow AI. Mais cette appropriation n’apparaît pas encore comme une évidence tant du côté des chefs d’entreprise que des collaborateurs, en particulier au sein des très petites, petites et moyennes entreprises. En 2024, les dirigeants de ces dernières sont 72 % à déclarer ne pas utiliser les IA génératives, et seulement 13 % disent vouloir s’y former, tandis que 14 % l’ont interdite ou ne veulent pas l’utiliser par choix44« IA génératives : opportunités et usages dans les TPE et PME », francenum.gouv.fr, 25 mars 2024.. Pour répondre à cet enjeu, des réseaux comme celui des chambres de commerce et d’industrie mettent en place des actions destinées à sensibiliser 20 000 entreprises à travers des formations et des expérimentations, un accompagnement territorialisé et personnalisé dans l’identification de leurs besoins et l’orientation vers des acteurs français ou européens pouvant proposer des outils d’IA ou en faciliter le déploiement.

Les collectivités ne sont pas en reste : dans une collectivité témoin, 45 % des agents pourraient voir leur métier plus ou moins transformé par les usages de l’IA45Institut national des études territoriales (INET), « Un outil de cartographie des métiers concernés par l’intelligence artificielle dans les collectivités. Une étude des élèves de l’INET 2023-2024 », avril 2024, p. 3.. Certaines collectivités ont donc déjà engagé des réflexions internes sur ces usages. C’est le cas de la métropole de Montpellier, dont la convention citoyenne organisée en 2023 et 2024 sur ces questions réclame la formation et l’accompagnement des agents. Le Centre national de la fonction publique territoriale (CNFPT) accompagne ce besoin de formation en proposant une nouvelle offre structurée autour d’une série de ressources, des formations à distance, des webinaires d’acculturation et des programmes sur mesure à destination des collectivités qui en font la demande. Pour autant, de nombreuses collectivités conservent une vision méfiante du développement des outils d’IA et de leur utilisation par leurs agents.

4. Soutenir l’apprentissage dans le cadre scolaire

L’école est naturellement l’un des vecteurs de cette appropriation de l’IA dès le plus jeune âge. Le ministère de l’Éducation nationale a engagé plusieurs expérimentations ces dernières années, telles que l’application d’adaptation des apprentissages MIA seconde (un service numérique de remédiation en français et en mathématiques). Il a également structuré une Communauté de réflexion en éducation sur l’intelligence artificielle (CREIA) destinée à assurer une veille et à diffuser auprès du corps enseignant des éléments permettant de comprendre et de s’approprier l’IA ainsi que de l’enseigner aux élèves.

Depuis la rentrée 2025, les élèves de quatrième et de seconde suivent un parcours de formation spécifique sur la plateforme PIX. Celui-ci leur permet de se familiariser avec les outils d’IA, d’en comprendre le fonctionnement et d’en mesurer les impacts environnementaux. L’introduction de l’intelligence artificielle dans les enseignements et programmes scolaires favoriserait d’ailleurs la mise en place de projets interdisciplinaires et encouragerait la collaboration entre les enseignants de différentes matières, au-delà des seules disciplines techniques ou scientifiques, dans une véritable logique d’humanités numériques46Voir Dominique Boullier, Sociologie du numérique, Armand Colin, Paris, 2018 ; Dominique Cardon, Culture numérique, Les Presses de Sciences Po, Paris, 2019.. Cela pourrait prendre la forme de projets d’étude en groupes, ce qui permettrait également de développer les softskills de travail en équipe, d’écoute et d’entraide, davantage valorisés à l’ère de l’IA. De même, les projets portés par les élèves et étudiants dans le cadre scolaire pourraient répondre à des problématiques concrètes de la classe, de l’école, voire de la ville ou du pays, ce qui aurait l’avantage de contribuer à la cohésion sociale.

En parallèle, des programmes ont déjà été lancés pour accompagner les professeurs dans leur appropriation des outils. Réseau Canopé propose par exemple des ressources dédiées en ligne et des actions dans ses ateliers départementaux. Ces actions de formation et d’accompagnement des enseignants revêtent une importance fondamentale, alors que certains syndicats affichent leur méfiance face au déploiement d’outils d’IA au sein des établissements scolaires.

À l’échelle locale, des partenariats voient également le jour. Dans les Alpes-Maritimes, la MIA développe son offre à destination des élèves en recevant ces derniers, en proposant des interventions en classe, en faisant circuler des expositions, mais également en accompagnant les enseignants via des actions de formation. Dans plusieurs départements, les équipes de Réseau Canopé accompagnent par ailleurs des collectivités dans le cadre des temps périscolaires que ces dernières organisent. Mais si ces partenariats se développent, le cadre scolaire demeure en général encore trop relativement fermé à l’intervention d’acteurs extérieurs à l’Éducation nationale. Pourtant, ceux-ci trouveraient toute leur place dans les programmes d’appropriation du numérique et de l’IA, alors même que les équipements utilisés par les élèves et les enseignants sont souvent fournis par les collectivités, lesquelles n’ont pas la possibilité d’accompagner directement leur appropriation en milieu scolaire.

5. Encourager la collaboration et la transversalité

La multiplicité des lieux qui encouragent et soutiennent l’appropriation de l’IA rend d’autant plus nécessaire un décloisonnement de l’accompagnement des citoyens, fondé sur une collaboration entre acteurs publics, privés et associatifs, mais aussi entre collectivités et Éducation nationale. En effet, il reste rare que les acteurs de la médiation soient invités à intervenir dans un cadre scolaire ou que des acteurs institutionnels mutualisent des ressources de formation avec des entreprises. La question de l’appropriation du numérique, et plus spécifiquement de l’IA, doit pourtant nous conduire à remettre en question cette séparation : nombre de questions qui se posent à l’école sont bien souvent proches de celles qu’on pourra retrouver dans un cadre administratif, familial ou professionnel.

Ce décloisonnement des politiques d’appropriation du numérique favoriserait l’investissement des acteurs privés dans ces dernières, qu’ils soient éditeurs de logiciels, fournisseurs de service ou distributeurs de terminaux. Ces acteurs profitent fréquemment des actions de médiation menées auprès du grand public, qui jouent parfois le rôle de véritable service après-vente de leurs outils. Certaines entreprises se sont déjà engagées dans ce domaine, en soutenant financièrement des programmes d’inclusion numérique, en faisant don de matériel ou en créant leurs propres dispositifs. Toutefois, ces initiatives tendent parfois à privilégier la prise en main de leurs solutions plutôt que l’émancipation des citoyens. De nombreux ponts restent donc à construire afin de mieux intégrer ces entreprises dans une coordination qui profiterait à l’ensemble des acteurs concernés. Une plus grande collaboration entre les collectivités et les entreprises proposant des outils et des solutions numériques – en particulier les start-up et les PME françaises et locales – permettrait à ces dernières d’utiliser le territoire national comme un vaste terrain d’expérimentation. Elles pourraient ainsi tester plus facilement et plus rapidement leurs solutions sur des cas d’usage concrets, tandis que les collectivités bénéficieraient gratuitement des expérimentations et des avancées générées.

Au-delà des partenariats, des propositions plus audacieuses envisagent l’instauration d’un système de « numériseur payeur », c’est-à-dire une taxe spécifique pour les grandes entreprises du numérique, comme le propose un avis récent de la Commission supérieure du numérique et des postes (CSNP)47Commission supérieure du numérique et des postes (CSNP), « Pour une politique nationale d’inclusion numérique adaptée aux besoins de nos concitoyens », avis n° 2024-08, 28 novembre 2024., voire pour les entreprises bénéficiant de la numérisation de leurs services (banques, assurances, etc.).

6. Développer la formation continue universitaire

Pour accompagner ce décloisonnement, les équipes universitaires spécialisées en sciences dures et en sciences humaines (comme les humanités numériques) pourraient être sollicitées à travers des formations payantes proposées par leur université ou leur école supérieure. Ces chercheurs en bénéficieraient en retour via le fléchage des crédits dégagés vers le financement de travaux ou de bourses de recherche et de thèse. Ce modèle, déjà adopté par certains établissements français, est largement déployé dans le système anglo-saxon à travers les programmes dits d’executive education (formation continue). Ces équipes d’universitaires formeraient les élus, les passeurs et les acteurs privés de leur territoire grâce à des formations de personnes en ligne de quelques heures à quelques jours. Ces formations payantes seraient prises en charge en grande partie par l’État dans le cas des élus et des passeurs.

Sur ce même type de format, des formations continues universitaires autour des humanités numériques et des enjeux éthiques et responsables du développement d’outils algorithmiques, à destination des concepteurs du même territoire, devraient être proposées. Au-delà des enjeux pédagogiques et financiers, cet investissement concourrait à l’intégration plus forte de l’écosystème universitaire au sein de coalitions de projets conduites à l’échelle territoriale en faveur de l’inclusion algorithmique et rassemblant collectivités, associations et acteurs privés.

V. Concevoir des technologies algorithmiques inclusives

1. Une gouvernance des algorithmes à plusieurs échelles

La gouvernance des algorithmes regroupe l’ensemble des méthodes et des bonnes pratiques destinées à se conformer à la loi ainsi qu’aux codes et autres principes éthiques conçus par l’entreprise ou l’organisation qui coordonne cette gouvernance. En cela, elle doit dépasser le simple cadre de la législation pour se montrer visionnaire dans la manière de concevoir et d’utiliser des outils numériques et algorithmiques au sein d’une organisation ouverte sur la société48Voir Mark Esposito, Aurélie Jean, Terence Tse et Guillaume Sibout, « Characterising Bias in Compressed Models », weforum.org, 3 octobre 2023.. Cette gouvernance requiert la coopération étroite entre équipes métiers, scientifiques et techniques dès la phase de formulation des problèmes et des spécifications, le renforcement des compétences des collaborateurs et des citoyens, la participation des utilisateurs, ainsi qu’une gestion rigoureuse des processus de collecte et de test des données. Elle inclut enfin l’application de bonnes pratiques de développement et la conduite d’évaluations régulières des algorithmes, de leur phase de validation à leur déploiement, jusqu’à leur utilisation à grande échelle49Voir Sara Hooker, Nyalleng Moorosi, Gregory Clark, Samy Bengio et Emily Denton, « AI: Why companies need to build algorithmic governance ahead of the law », Cornell University, arxiv.org, 2010.03058v2, 18 décembre 2020..

Cette gouvernance doit évoluer dans le temps avec un retour (ou feedback) des parties prenantes, y compris les utilisateurs de la technologie. Le lien avec l’utilisateur final doit aussi favoriser sa montée en connaissance. Cela passe par la mise à disposition d’informations claires sur la solution d’IA utilisée : le type d’algorithme déployé, les données mobilisées pour sa construction, ou encore les actions menées à son égard (recommandation, personnalisation d’un service, détection de comportements particuliers). Il doit également intégrer sa montée en compétences par la formation continue des bases de l’IA et de sa manipulation afin de prendre en main l’outil avec justesse. Ce qui, par exemple, aurait pu éviter la controverse en 2021 de l’application Affelnet destinée à orienter les collégiens vers un lycée. Le fonctionnement de l’outil avait été mal expliqué aux élèves et aux parents, ce qui a entraîné des incompréhensions et potentiellement des discriminations liées au genre ou à la classe sociale50Marion Oury, La réforme Affelnet à Paris : un voyage au pays où 15=20, Fondapol, octobre 2023.. En cela, être davantage transparent sur les mécanismes du fonctionnement de l’outil et le type de données sur lequel il a été conçu permettrait une meilleure compréhension de ces solutions par les utilisateurs.

Cette gouvernance doit aussi intégrer une plus grande transparence sur les méthodes utilisées afin de s’assurer d’une bonne conception et utilisation des outils algorithmiques. Pour une collectivité, une instance de l’État ou une entreprise, partager sa gouvernance permet de conforter la confiance nécessaire entre les acteurs (publics et/ou privés) et d’assurer une meilleure inclusion algorithmique à travers, par l’exemple, l’éducation et la formation. La transparence par le partage de ses erreurs et des moyens pour les réparer en fait partie.

Une gouvernance d’excellence permet de contourner les menaces des outils algorithmiques évoqués précédemment, telles que la discrimination technologique, l’exploitation de main-d’oeuvre dans des conditions inacceptables (digital labor) ou encore l’impact environnemental. L’enjeu étant de s’interroger au bon moment et sur les bons sujets tout au long du cycle de vie d’un algorithme, mais aussi de tester correctement les outils et d’adopter des pratiques qui permettent de réduire le risque, lequel grandit à mesure qu’on innove dans la science algorithmique et ses applications.

Enfin, cette gouvernance doit être pensée, réalisée et appliquée à plusieurs échelles : celle de la collectivité comme celle de l’État. Elle doit décliner ses principes opérationnels jusqu’au niveau de l’utilisateur et du citoyen, qui n’est pas toujours l’utilisateur final. L’objectif est de rester connecté au terrain et à ses problématiques, afin de concevoir des solutions efficaces et pérennes. Cette gouvernance repose aussi sur la coconstruction des outils et des bonnes pratiques, ainsi que sur la formation de toutes les parties prenantes. Dans les Alpes-Maritimes, l’Observatoire des impacts technologiques, économiques et sociétaux de l’intelligence artificielle et du numérique (Otésia) a créé un outil de mesure de l’impact de l’IA destiné à comprendre les dynamiques à l’oeuvre et à orienter les décisions publiques à l’échelle du territoire. Dans le même temps, il a mis en place des groupes de travail dont l’objectif est de favoriser l’acceptabilité de l’IA et d’accompagner son adoption.

2. Une coconception des outils et des mesures publics

La coconception présente plusieurs avantages tant sur la pertinence des données récoltées et des faits analysés que sur l’efficacité de la solution finalement conçue et mise en place. Cette approche s’applique aussi bien à la création d’une solution algorithmique qu’à l’élaboration de politiques publiques, à l’échelle locale comme nationale. Elle est toutefois plus efficace au niveau des collectivités, où l’agilité des structures et la proximité entre décideurs et citoyens facilitent sa mise en oeuvre. Beaucoup d’outils permettent de mettre en oeuvre la coconception. Les bases de données ouvertes en sont un exemple. À New York, les citoyens utilisent largement la plateforme mise à leur disposition pour signaler leurs observations, leurs incompréhensions, leurs plaintes ou encore proposer des solutions. On peut aussi citer les services open source, qui incluent la mise à disposition des codes. À Paris, la solution Lutèce illustre cette démarche. Elle sert de socle technique à un certain nombe de services proposés par la ville.

Des collectivités sont pionnières dans cette association des citoyens à la gouvernance du numérique et de l’IA sur leur territoire. La Ville de Rennes a mis en place un Conseil citoyen du numérique responsable, composé de quarante citoyens tirés au sort et représentatifs de la population. Le dernier rapport d’étonnement de ce conseil, suivant une saisine de la ville sur l’IA, fait état de la méthode déployée et des enseignements qu’en tirent les citoyens. Après une première phase d’approche de l’IA, structurée autour de l’audition de personnalités qualifiées par le conseil, ce dernier a dessiné des premières lignes rouges et des points d’attention à destination des services municipaux dans leur utilisation des systèmes d’IA. Surtout, le conseil a conclu la première phase de ces travaux par une interrogation relative à « la place, ou plutôt la non-place, occupée par les citoyens tant dans la réflexion que dans le contrôle ou la gouvernance des politiques numériques, en particulier celles ayant trait à la donnée et à l’IA51Ville de Rennes-Conseil citoyen du numérique responsable, « Point d’étape suite saisine par la Ville de Rennes. Quelle place pour l’intelligence artificielle dans nos vies de Rennaises et de Rennais ? Quelles sont les influences de l’IA sur nos opinions politiques, nos libertés fondamentales, notre sécurité ? », février 2024, p. 11. », avant de demander leur intégration dans l’élaboration et la gouvernance des stratégies données de la ville.

S’il semble délicat d’inclure les citoyens dans la conception pratique des algorithmes – il ne s’agit pas de former en quelques mois plus de soixante millions d’ingénieurs IA –, plusieurs outils permettent de les associer à cette démarche en amont (recueil de leurs besoins, expression de points de vigilance, définition des fonctionnalités à inclure ou conception d’interfaces ergonomiques) comme en aval (évaluation des outils créés et de leur déploiement).

De la même manière, plusieurs collectivités ont engagé des conventions et des débats destinés à dessiner les contours des usages de l’IA utiles et souhaitables à leur échelle. L’association Les Interconnectés a dressé en mars 2025 un premier bilan de plusieurs de ces exercices citoyens, faisant émerger des premiers points d’attention dans le déploiement de systèmes d’IA à l’échelle locale (déshumanisation des services publics, surveillance…), mais également des demandes (acculturation, transparence et explicabilité des algorithmes, gouvernance partagée, mesure de l’utilité des outils déployés…)52Voir « Faire de l’IA responsable une doctrine partagée », Manifeste, #4, mars 2025, p. 2.. Le partage des méthodes de gouvernance entre collectivités territoriales est clé dans les efforts à mener vers plus d’inclusion algorithmique. Cela suppose de partager les stratégies, les méthodes et les outils de gouvernance.

Enfin, la gouvernance des algorithmes doit encourager la mutualisation des moyens et des ressources entre collectivités. Cela concerne à la fois les talents techniques et scientifiques – par exemple les directeurs des systèmes d’information, qui gèrent les infrastructures et la sécurité, ou encore les ingénieurs data et IA, qui pilotent la transformation numérique. La mutualisation s’applique aussi aux infrastructures, comme les serveurs, ainsi qu’aux initiatives destinées à réduire les menaces liées à l’IA. Il peut s’agir d’éviter la multiplication inutile des infrastructures, de favoriser le recyclage des ordinateurs, téléphones et autres matériels, ou encore de proposer des contenus et des moyens de formation pour un usage plus durable et respectueux de l’environnement. Le rapport sénatorial déjà cité insiste d’ailleurs sur plusieurs leviers : l’utilisation d’énergies plus propres, le recours à des modèles d’IA préentraînés, moins gourmands en données et en énergie, et la mise en commun de moyens locaux, comme des infrastructures partagées, afin de limiter le transport inutile de données53Amel Gacquerre et Jean-Jacques Michau, op. cit..

VI. Recommandations

Les recommandations qui suivent s’inscrivent dans la continuité des réflexions et propositions détaillés précédemment et visent à tracer une feuille de route pragmatique et ambitieuse :

1. Orienter la transformation vers des besoins et des problématiques territoriales ;

2. Encourager et faciliter la mutualisation des moyens et des ressources entre instances territoriales ;

3. Encourager et faciliter le fonctionnement et le dynamisme transversal au sein des collectivités pour sortir d’une logique en silos ;

4. Faire piloter la transformation IA et l’inclusion algorithmique par les équipes data et IA, ainsi que par les équipes métiers ;

5. Sanctuariser les budgets consacrés aux politiques de médiation et d’inclusion numérique et algorithmique ;

6. Dans le cadre scolaire, développer des projets destinés à répondre à des problématiques concrètes de la classe, de l’école, voire de la ville ou du pays ;

7. Faciliter les collaborations entre les acteurs privés, les institutions publiques et le monde associatif ;

8. Favoriser l’expérimentation de la part de start-up et des TPE-PME du territoire sur des cas d’usages de la collectivité ;

9. Encourager l’offre de formations payantes offertes par les universités et les écoles supérieures du territoire ;

10. Mettre en place une gouvernance territoriale d’excellence des algorithmes ;

11. Encourager la coconception des solutions d’IA au sein des territoires pour favoriser l’émergence d’IA publiques locales ;

12. Partager librement les méthodes de gouvernance entre collectivités et instances territoriales.

Conclusion – Faire de l’inclusion algorithmique un levier de cohésion et de souveraineté

Plus que jamais, à l’ère d’IA toujours plus puissantes et présentes dans nos quotidiens personnels comme professionnels, l’inclusion algorithmique doit être reconnue comme un pilier essentiel de l’égalité des chances entre citoyens. Elle constitue la garantie de retombées économiques mieux partagées et d’un numérique réellement au service de chacun, tout en permettant de contenir les risques associés à ces technologies. Ces efforts ne peuvent rester théoriques : ils doivent s’incarner dans chaque territoire et s’appuyer sur les acteurs de terrain, au plus près des citoyens.

Cette inclusion algorithmique repose sur une conception rigoureuse et responsable des outils, associant élus et habitants, mais aussi sur l’expérimentation locale, la formation tout au long de la vie, l’implication des universités, la coopération entre acteurs publics et privés et la mutualisation des ressources à l’échelle territoriale comme nationale.

L’inclusion algorithmique dépasse la seule appropriation individuelle ou collective des outils. Elle ouvre la voie au renforcement d’une souveraineté technologique à la fois territoriale et nationale. Elle se traduit par l’émergence et le développement d’acteurs locaux et nationaux, ainsi que par la création de solutions adaptées aux besoins et aux spécificités de chaque territoire.